KAIST

BREAKTHROUGHS

Research Webzine of the KAIST College of Engineering since 2014

Spring 2025 Vol. 24이 연구는 그래프 신경망이 언제 그리고 왜 강력해지는지 설명하는 새로운 이론을 제안합니다. 이 이론으로 연구진은 연결성과 특성 간의 의존성이 그래프 신경망의 효과를 결정한다는 것을 입증합니다.

커뮤니티의 일원으로서의 스스로를 상상해 봅시다. 우리 모두는 서로 연결하며 하나의 거대한 네트워크를 이룹니다. 네트워크에서 각 개인(정점)은 고유한 특성을 가지며, 이러한 특성은 종종 연결에 영향을 미칩니다. 사람들은 성별이라는 특성에 따라 친구를 사귀는 경향이 있지만, 키와 같은 다른 특성에는 그러한 경향이 나타나지 않습니다. 그러나 흥미롭게도, 성별이 연결 형성에서 키에 편향을 주기 때문에 사람들은 여전히 비슷한 키를 가진 사람들과 연결됩니다. 즉, 특성과 연결은 복잡한 상호작용을 가집니다.

그래프 신경망(GNN)은 이러한 네트워크를 분석하는 데 있어 선도적인 딥러닝 기법입니다. 그러나 그들의 블랙박스 특성으로 인해 GNN이 언제 그리고 왜 강력한지를 밝히는 것은 기술적인 도전 과제입니다. 특히, 특성과 연결 간의 관계가 GNN에 어떻게 영향을 미치는지는 명확하지 않았습니다. "그래프 위상에서의 특성 분포가 그래프 합성곱의 효과를 매개함: 동류성 관점"이라는 최근 연구는 이 격차를 해소하는 것을 목표로 했습니다.

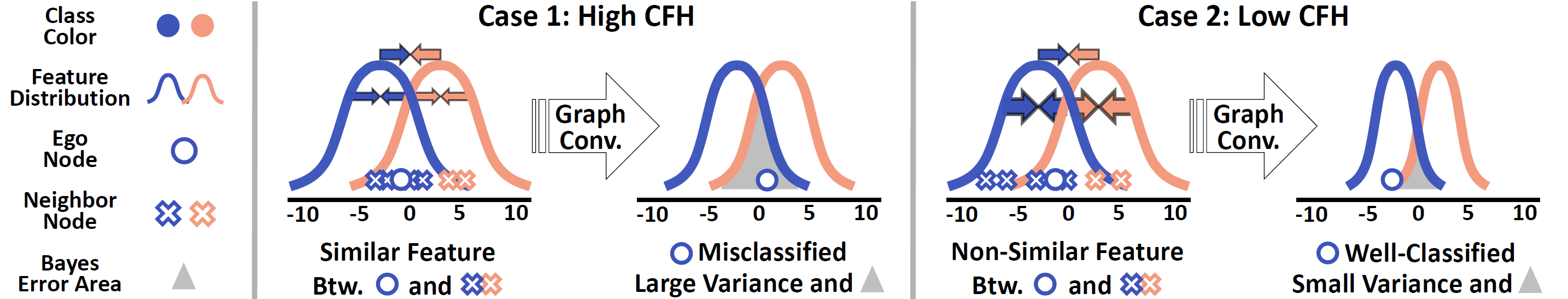

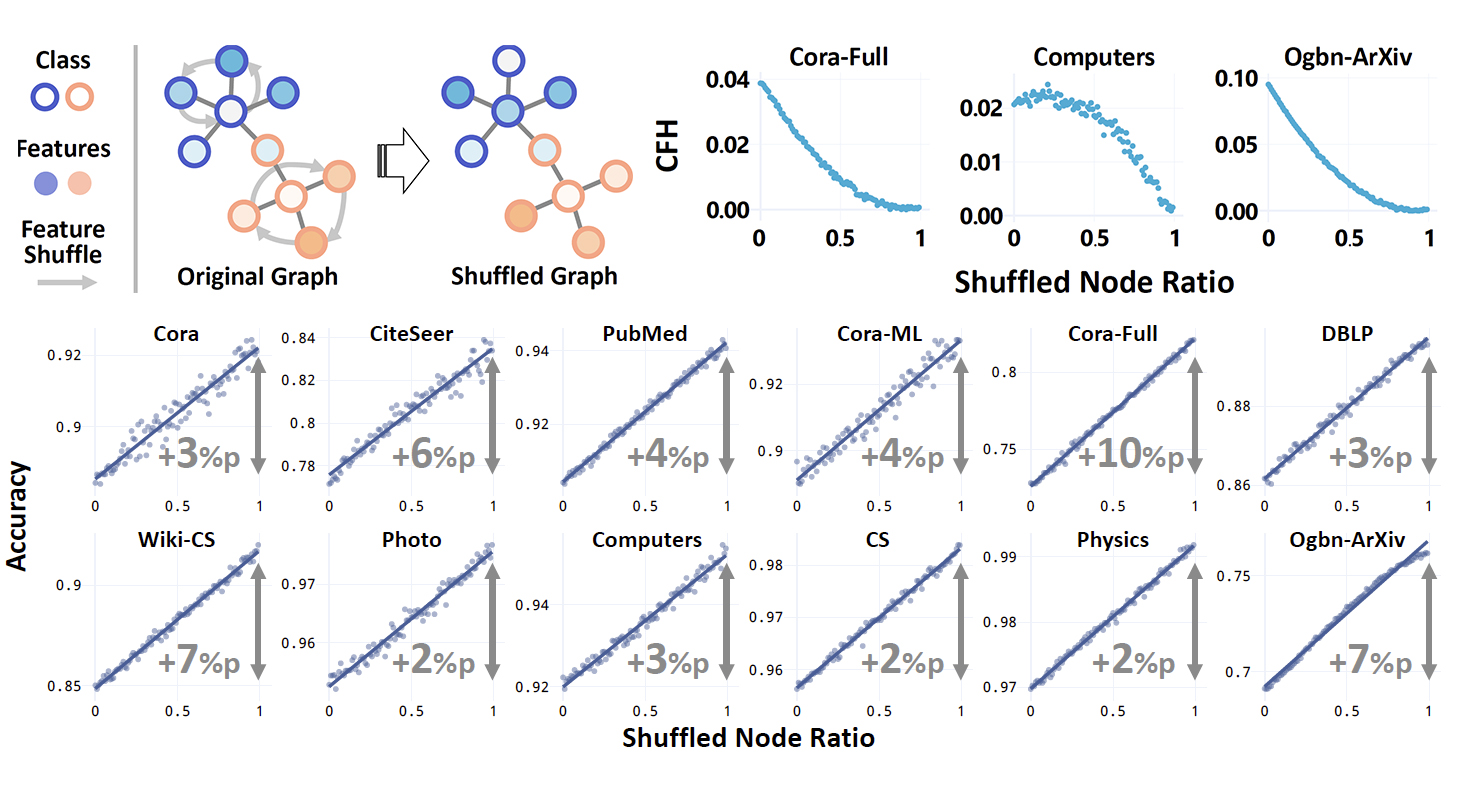

첫 번째 과제는 특성과 연결 간의 복잡한 관계를 측정하는 것이었습니다. 예를 들어, 소셜 네트워크에서 성별과 키가 특성으로 주어졌을 때, 측정값은 성별에 대해 높은 점수를, 키에 대해 낮은 점수를 부여해야 합니다. 이에 따라 연구자들은 클래스 제어 특성 동류성(CFH)을 정의했습니다. CFH는 잠재적인 혼란 변수를 통제한 후, 정점 쌍의 특성 유사성이 연결 형성에 미치는 영향을 측정합니다.

GNN의 CFH와 관련된 수학적 분석이 그 다음 과제였습니다. 이전의 분석 프레임워크에서는 CFH가 다른 중요한 그래프 통계량과 크게 공변하여, GNN에 대한 CFH의 효과를 명확히 파악하기 어려웠습니다. 이에 해당 연구진은 GNN 분석에서 CFH를 특정하게 조절할 수 있는 새로운 수학적 프레임워크를 도입했습니다. 이러한 기술 혁신을 통해 GNN의 다양한 CFH 수준에서의 동작을 처음으로 분석할 수 있게 되었습니다.

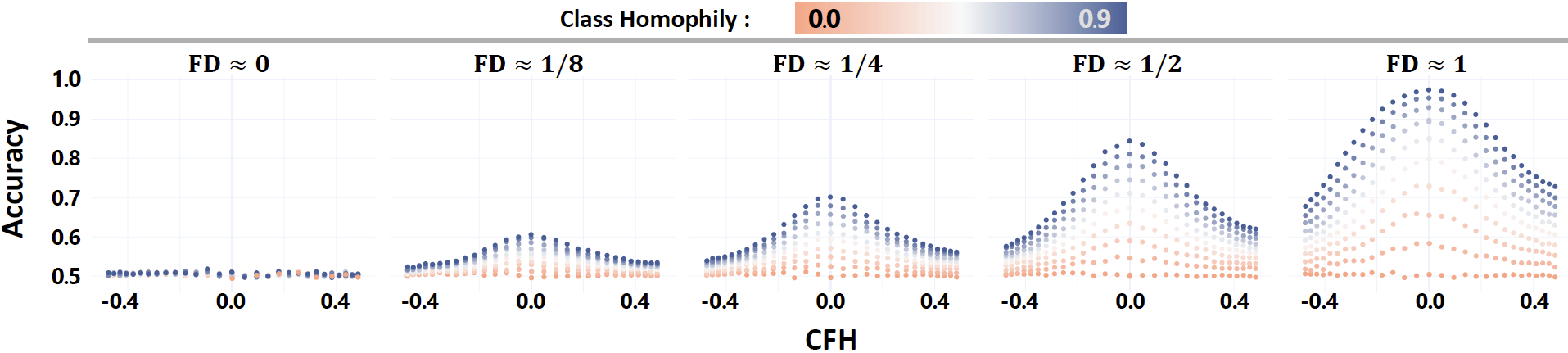

수학적 분석 결과, CFH가 GNN의 효과를 결정하는 것으로 나타났습니다. 구체적으로, 연구자들은 CFH가 GNN이 각 특성을 특성 분포의 평균으로 끌어당기는 능력을 조절한다는 것을 발견했습니다(그림 1). 실제로, CFH가 작을수록 동일한 클래스의 정점 특성이 더 유사해질 수 있으므로, GNN이 정점 클래스를 더 잘 예측했습니다(그림 2).

연구진은 이 이론을 실증적으로도 입증했습니다. 24개의 네트워크 벤치마크 데이터셋을 사용하여, 각 데이터셋의 CFH를 낮추기 위해 정점 특성을 무작위로 섞었습니다(그림 3). 그들의 이론과 일치하게, 정점 특성을 섞는 것(즉, CFH를 낮추는 것)은 GNN 성능을 향상시켰습니다(그림 4). 따라서, 저자들은 CFH가 GNN이 언제 그리고 왜 강력해지는지를 설명한다고 결론지었습니다.

딥러닝 모델의 작동 메커니즘을 이해하는 것은 딥러닝 연구의 중요한 기반이며, 특히 그들의 블랙박스 특성으로 인해 도전적입니다. GNN은 점점 더 인기를 얻고 산업에 적용되고 있습니다. 이러한 상황에서. 이번 연구는 새로운 GNN 이론을 통해 GNN 연구와 응용을 촉진하는 새로운 방향을 열어줄 수 있을 것으로 기대됩니다.

이수용 박사학생이 제1저자로 진행한 본 연구는 “Feature Distribution on Graph Topology Mediates the Effect of Graph Convolution: Homophily Perspective” 라는 제목으로International Conference on Machine Learning 2024 에 출판되었다.